OpenMPI编程学习笔记

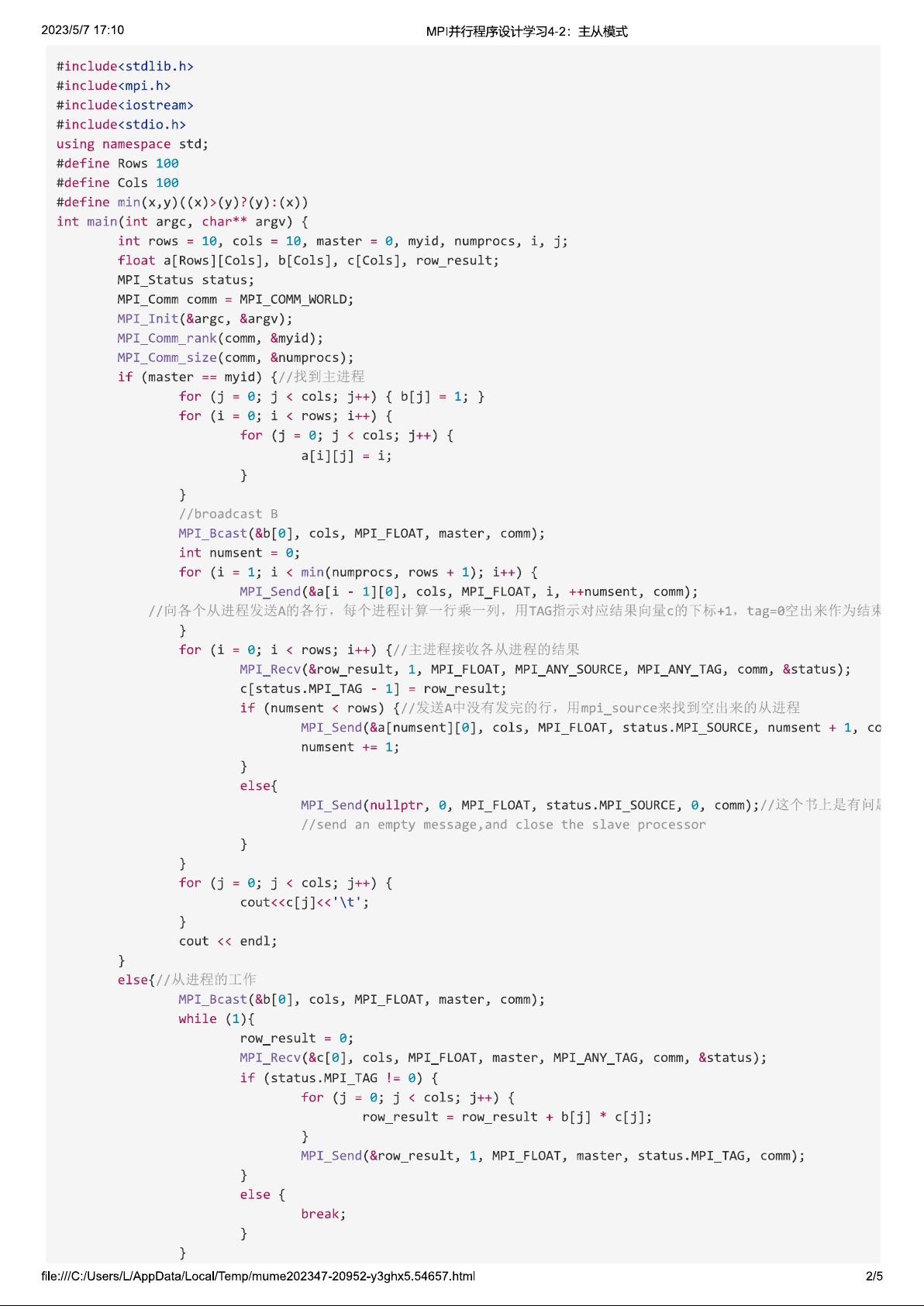

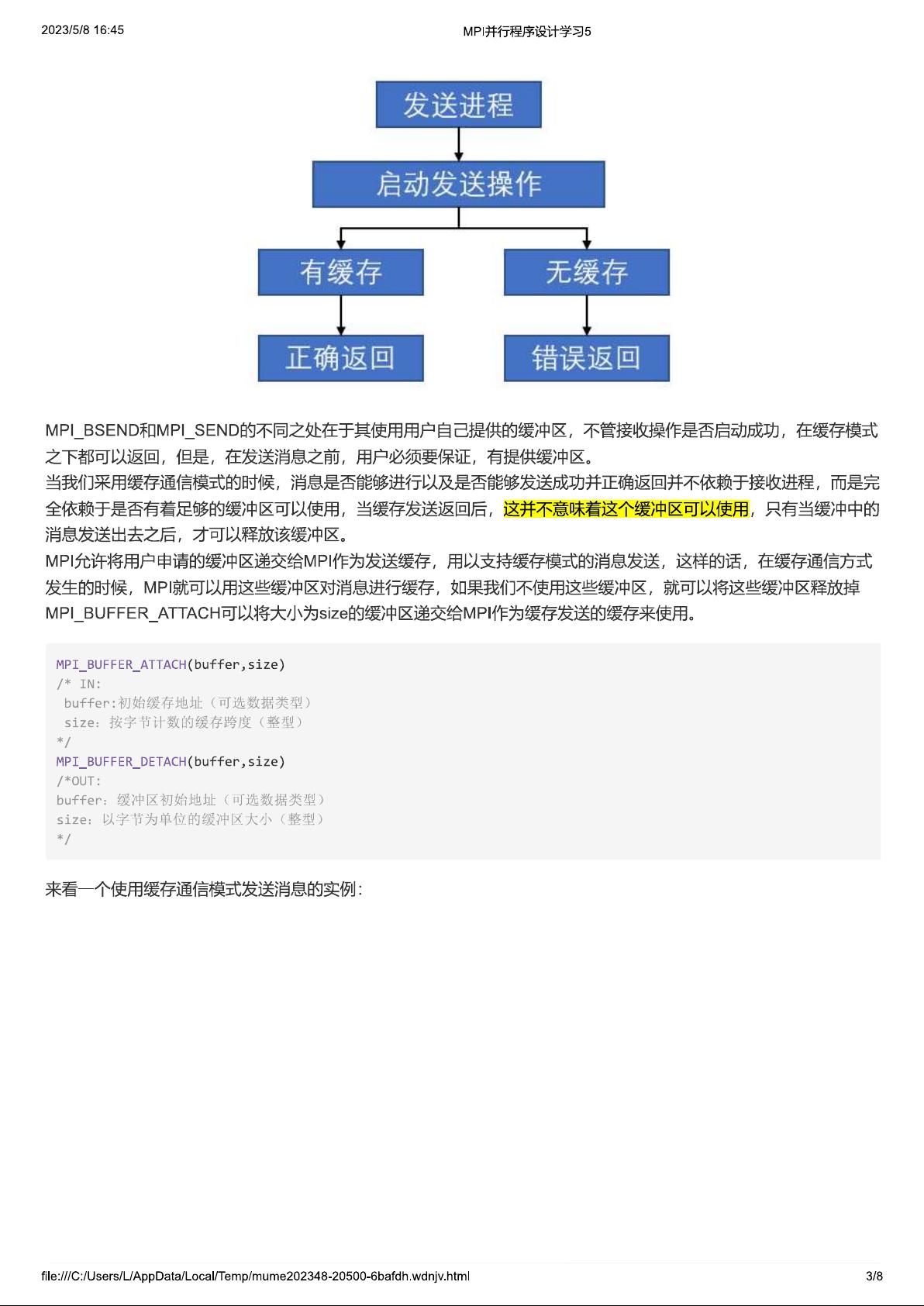

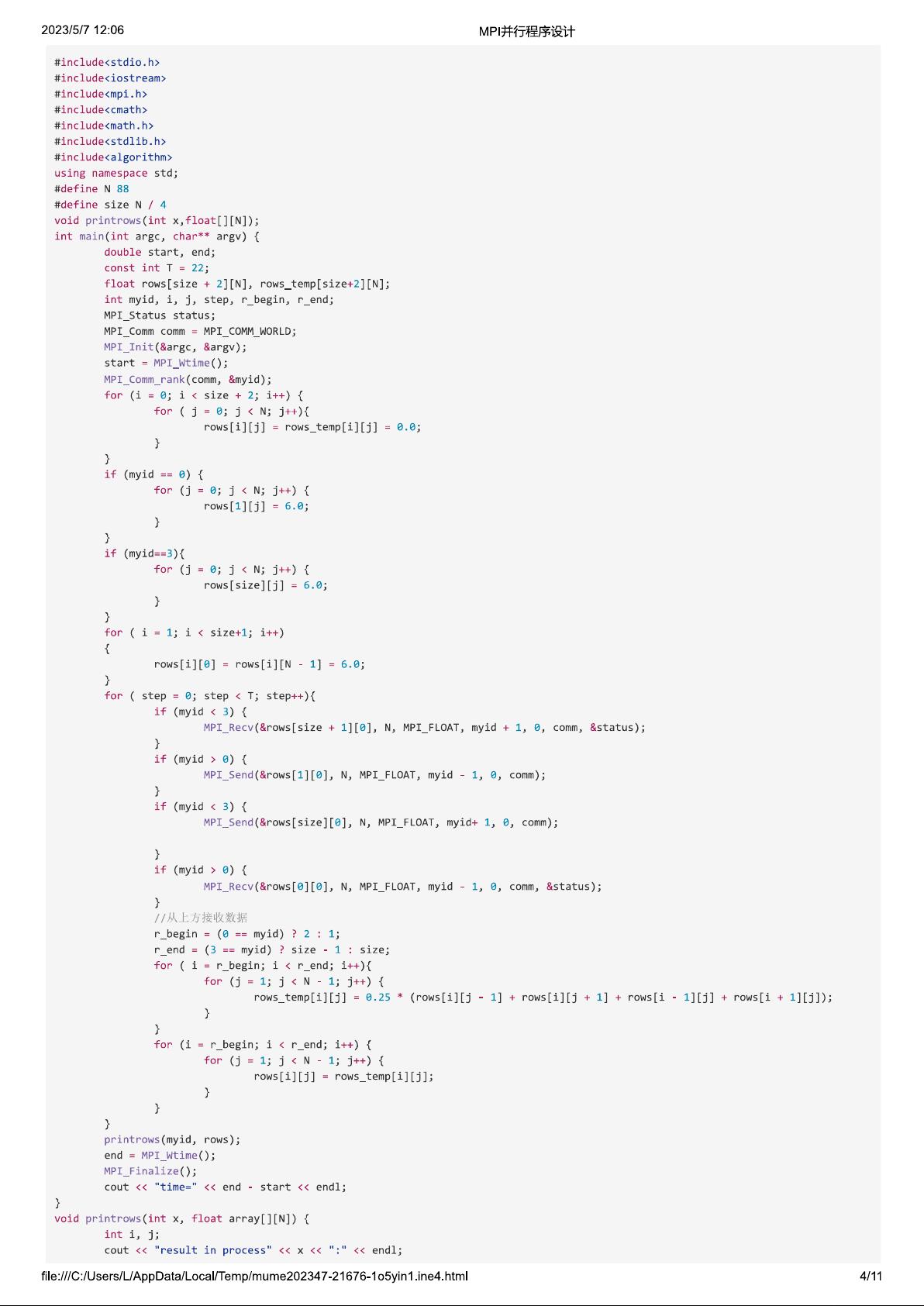

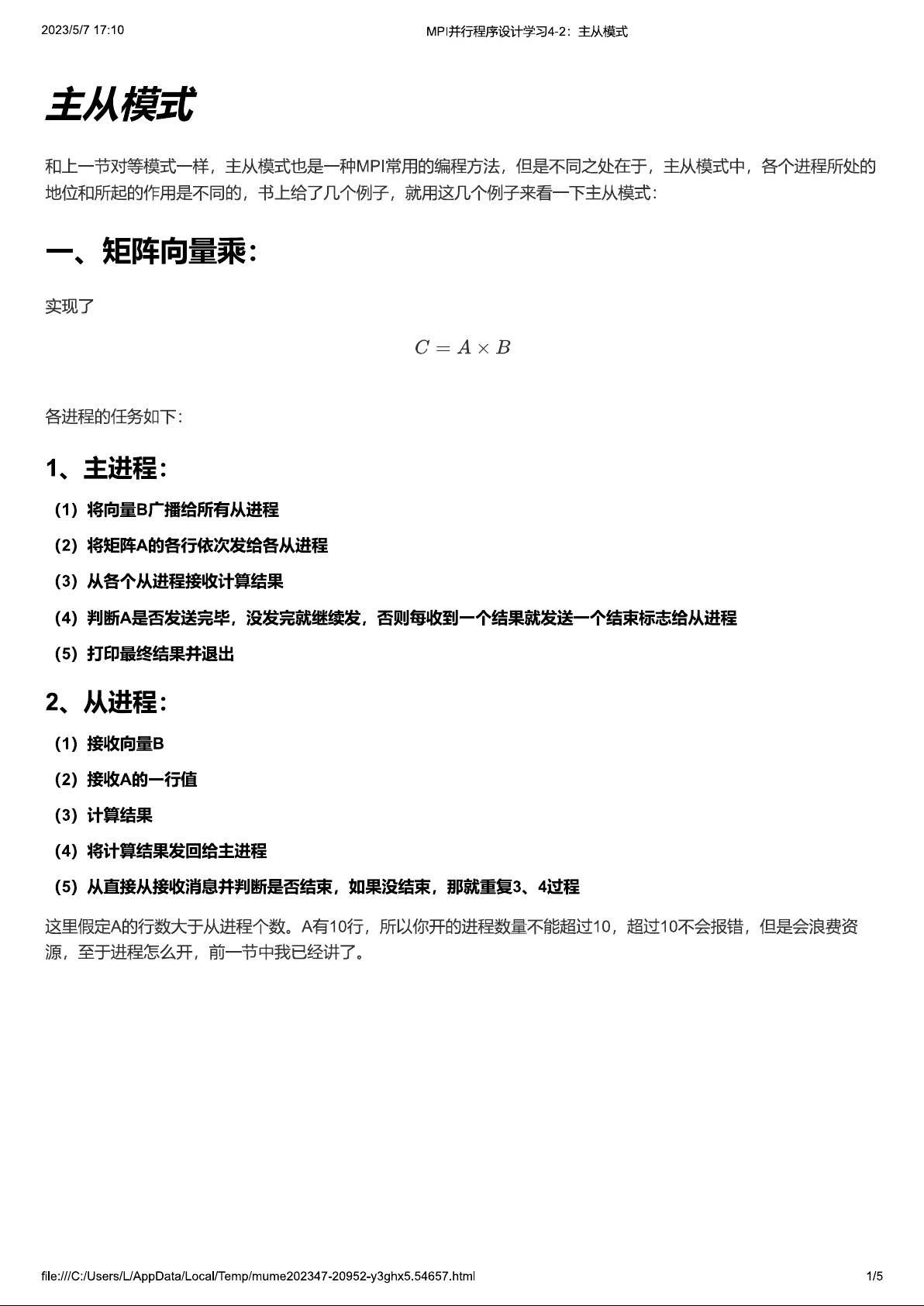

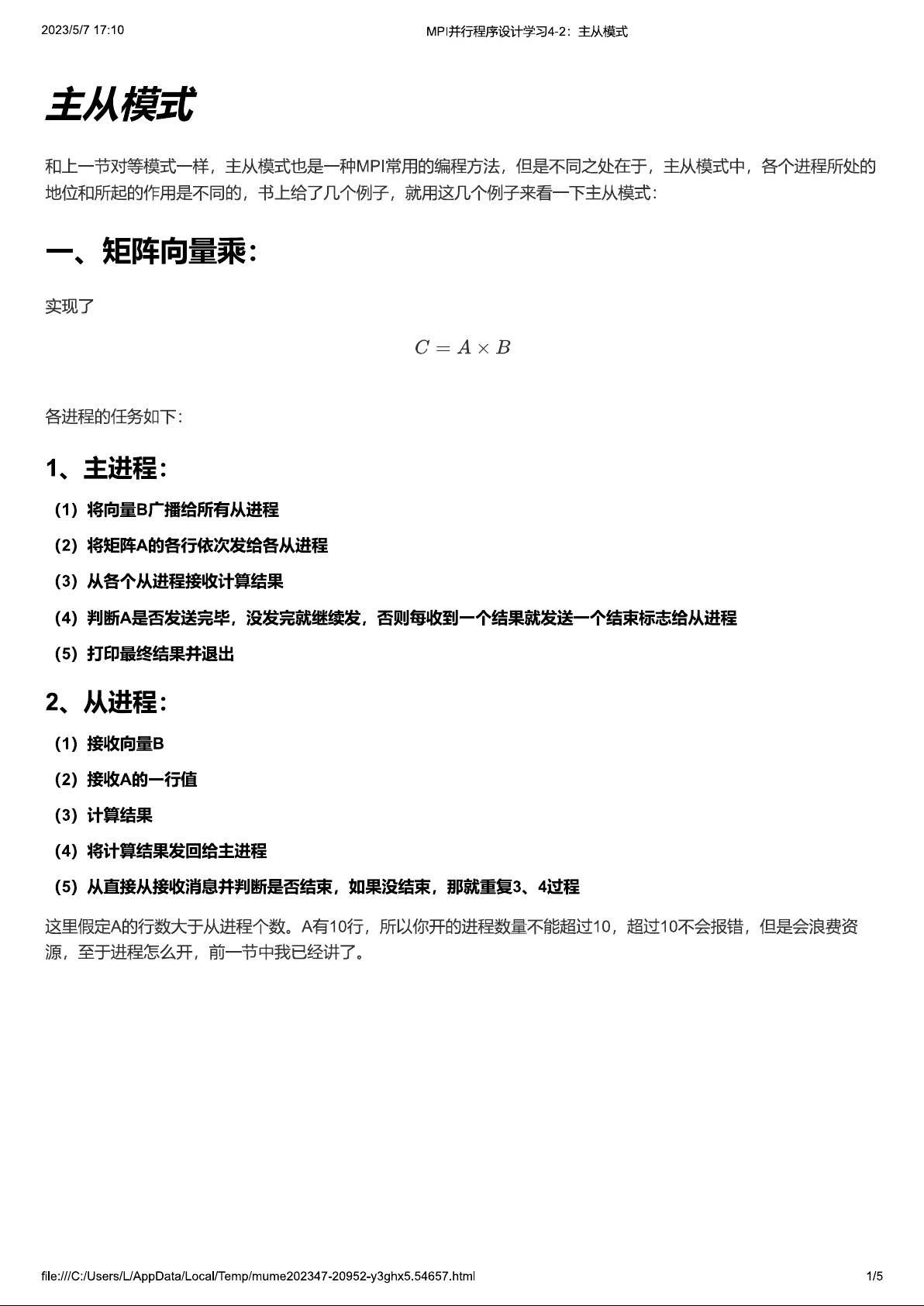

OpenMPI(Message Passing Interface)是一种开源的并行计算框架,用于构建高性能的分布式内存并行应用。它提供了标准的MPI接口,使得程序员可以编写跨平台的并行程序,支持多种编程语言,如C、C++、Fortran等。OpenMPI在高性能计算领域广泛使用,特别是在超级计算机和大规模集群上。 在学习OpenMPI的过程中,首先要理解MPI的基本概念。MPI是一种通信协议,定义了一系列函数,如`MPI_Init`、`MPI_Finalize`、`MPI_Send`、`MPI_Recv`等,用于进程间的数据交换。在OpenMPI中,程序由多个进程(process)组成,这些进程可以分布在多台机器上,通过MPI函数进行通信和协作。 `MPI_Init`和`MPI_Finalize`是每个MPI程序的开始和结束标志。`MPI_Init`初始化MPI环境,而`MPI_Finalize`则关闭所有资源并退出。在它们之间,可以使用其他MPI函数进行并行操作。 `MPI_Send`和`MPI_Recv`是基础的点对点通信函数。`MPI_Send`用来发送数据,而`MPI_Recv`接收数据。这两个函数必须配合使用,确保发送和接收的同步,否则可能会出现数据丢失或数据竞争的问题。通常会使用非阻塞版本的`MPI_Isend`和`MPI_Irecv`来实现更复杂的并发操作。 除了点对点通信,MPI还提供了集合通信(collective communication)功能,如`MPI_Bcast`(广播)、`MPI_Gather`(聚集)、`MPI_Scatter`(分散)和`MPI_Reduce`(归约)。这些操作允许数据在整个进程群体中分布或聚合,是并行计算中的关键组成部分。 OpenMPI提供了额外的功能,如动态进程管理,可以在运行时添加或删除进程,这在处理不确定数量的计算任务时非常有用。此外,OpenMPI还支持各种网络层次结构,包括InfiniBand、TCP/IP等,可以根据硬件环境选择最佳的通信方式。 在实际编程中,理解OpenMPI的进程管理模型至关重要。每个MPI程序可以看作是由一个主进程(通常是 rank 0)和其他工作进程组成的。主进程通常负责分配任务,而工作进程执行任务。通过`MPI_Comm_rank`和`MPI_Comm_size`可以获取当前进程的rank和总进程数,从而实现不同进程间的差异化操作。 学习OpenMPI的笔记通常会涵盖以上内容,并可能包括错误处理、性能调优、并行算法的设计与实现等方面。通过实践编写并行程序,结合MPI学习笔记中的例子和解释,能够深入理解和掌握OpenMPI的使用,为开发高效的并行应用打下坚实基础。阅读提供的PDF文件,你将有机会进一步探索OpenMPI的细节,提高你的并行编程能力。

MPI学习笔记PDF.zip (6个子文件)

MPI学习笔记PDF.zip (6个子文件)  MPI学习笔记PDF

MPI学习笔记PDF  MPILearn3不知道为什么,图片显示不出来.pdf 1.06MB

MPILearn3不知道为什么,图片显示不出来.pdf 1.06MB MPILearn1.pdf 1.67MB

MPILearn1.pdf 1.67MB MPILearn5-通信模式.pdf 1.27MB

MPILearn5-通信模式.pdf 1.27MB MPILearn4-2.pdf 965KB

MPILearn4-2.pdf 965KB MPILearn2.pdf 1.57MB

MPILearn2.pdf 1.57MB MPILearn4.pdf 2.25MB

MPILearn4.pdf 2.25MB- 1

- 粉丝: 168

- 资源: 5

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功