Word2Vec Tutorial - The Skip-Gram Model · Chris McCormick.pdf

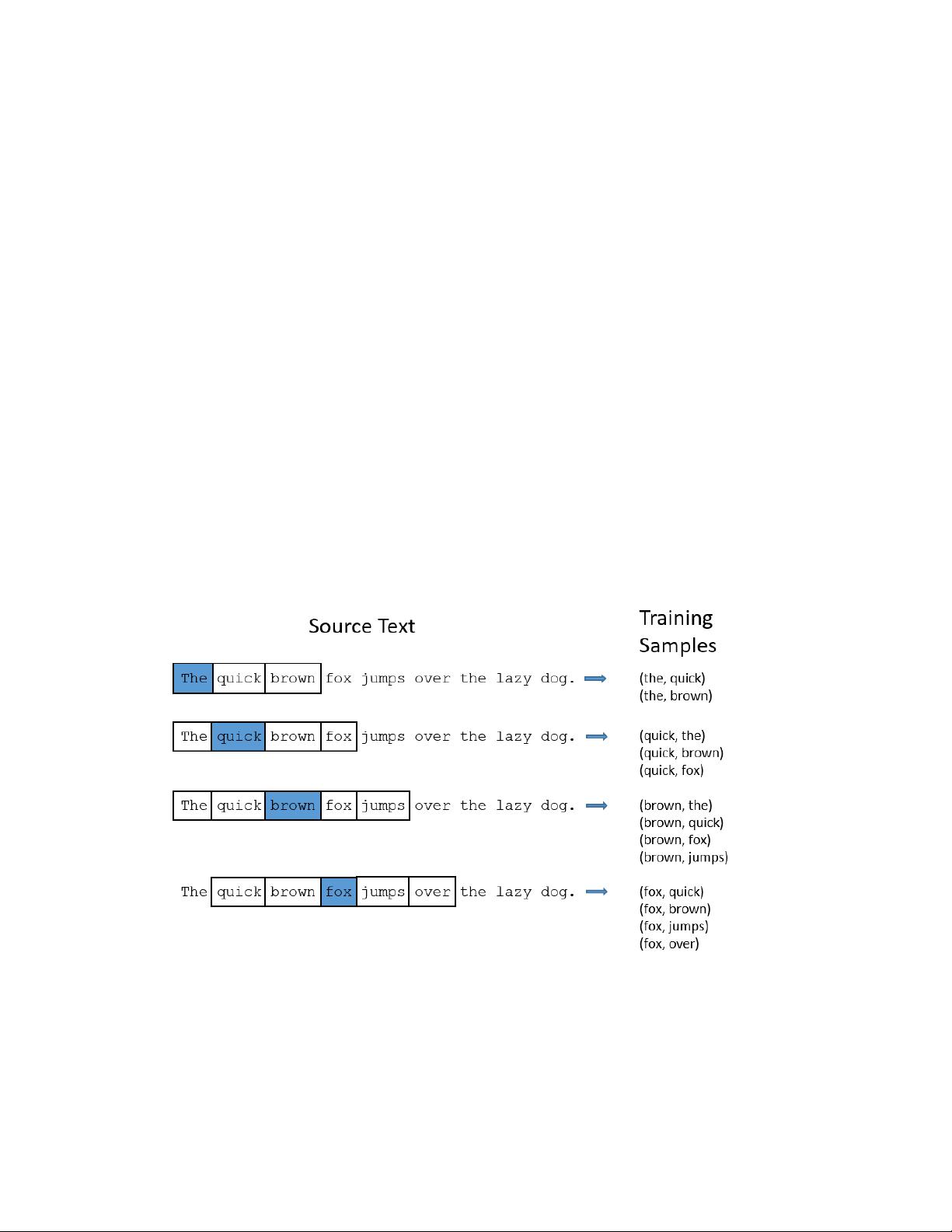

### Word2Vec教程:Skip-Gram模型详解 #### 摘要 本文旨在深入解析Word2Vec中的Skip-Gram模型架构及其工作原理。Word2Vec是一种流行且有效的词嵌入方法,它通过将词语映射到低维向量空间来捕捉语义关系。Skip-Gram模型是Word2Vec算法中的两种主要模型之一(另一种为CBOW模型),其目标是从给定的目标词预测上下文词。本文将重点介绍Skip-Gram模型的基本结构、训练过程以及如何从中提取词向量。 #### Word2Vec简介 Word2Vec是由Google在2013年提出的一种高效词嵌入学习算法,它能够将词语转换成固定长度的向量表示,这些向量不仅能够保留词语的语义信息,还能捕捉到词语之间的相似性和关系。Word2Vec基于浅层神经网络,主要有两种模型:连续词袋模型(CBOW)和Skip-Gram模型。 #### Skip-Gram模型概述 **Skip-Gram模型**是一种用于词嵌入学习的方法,它的核心思想是通过给定一个中心词(目标词)来预测其周围的上下文词。与CBOW模型相反,CBOW模型是通过给定一个上下文词序列来预测其中心词。 #### Skip-Gram模型架构 Skip-Gram模型的架构相对简单,在最基础的形式下,它由以下几个部分组成: 1. **输入层**:通常由词向量矩阵构成,每个词在词典中有一个唯一索引。 2. **隐藏层**:一个全连接层,用于学习词向量。 3. **输出层**:用于预测给定中心词时上下文词的概率分布。 #### 工作原理 1. **输入词向量**:对于输入的中心词,将其索引转换为对应的词向量,这是隐藏层的权重矩阵的一部分。 2. **隐藏层计算**:隐藏层通过简单的矩阵乘法操作,将输入词向量转化为中间表示。 3. **输出层计算**:输出层负责将隐藏层的输出转换为对所有可能上下文词的概率估计。这通常是通过softmax函数实现的,softmax函数可以将隐藏层的输出转换为概率分布。 4. **损失函数**:采用交叉熵损失函数衡量预测概率分布与实际上下文词分布之间的差异。 #### 训练过程 - **正例采样**:对于每个中心词,从其上下文中随机选择一个或多个词作为正例。 - **负例采样**:随机选择词汇表中的词作为负例,用于增强模型的泛化能力。 - **梯度下降**:通过反向传播调整权重矩阵以最小化损失函数。 #### 特点与优势 - **简单性**:Skip-Gram模型结构简单,易于理解和实现。 - **灵活性**:可以处理不同长度的上下文窗口,适应各种语言结构。 - **高质量词向量**:能够捕捉词语间的复杂关系,如同义词、反义词等。 #### 应用场景 - **自然语言处理**:文本分类、情感分析、机器翻译等领域。 - **推荐系统**:通过理解用户偏好进行个性化推荐。 - **知识图谱构建**:利用词向量辅助实体链接、关系抽取等任务。 #### 总结 本文详细介绍了Word2Vec中的Skip-Gram模型,包括其架构、工作原理、训练过程以及应用场景。通过训练Skip-Gram模型,我们可以获得高质量的词向量,这些词向量不仅能够保留词语的语义信息,还能够捕捉词语之间的复杂关系。Skip-Gram模型因其简单性和有效性,在自然语言处理领域得到了广泛应用。

剩余7页未读,继续阅读

- 粉丝: 2

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- MBR污水一体化处理系统(集装箱)工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- lattice diamond3.11的license文件

- vsvbxcygsyzgvytfvdyvs

- DJS-042-锁螺丝机方案工程图机械结构设计图纸和其它技术资料和技术方案非常好100%好用.zip

- FMASTERSW3.2版本

- qemu上运行Linux系统开启并验证IMA功能

- HE-Drive-main.zip

- mysql安装配置教程.txt

- mysql安装配置教程.txt

- mysql安装配置教程.txt

- 汇川伺服6V30-EOE-MXL文件-037515

- 2024中国CIO&CDO现状、挑战及未来趋势研究报告

- 鼠标连点器+自动单机+录制点击

- 4G DTU串口数据采集网关设计全套资料(源码、原理图、外壳文件、产品手册).zip

- 利用Python绘制装饰圣诞树的技术实例

- 测试程序:qabstractvideosurface

信息提交成功

信息提交成功