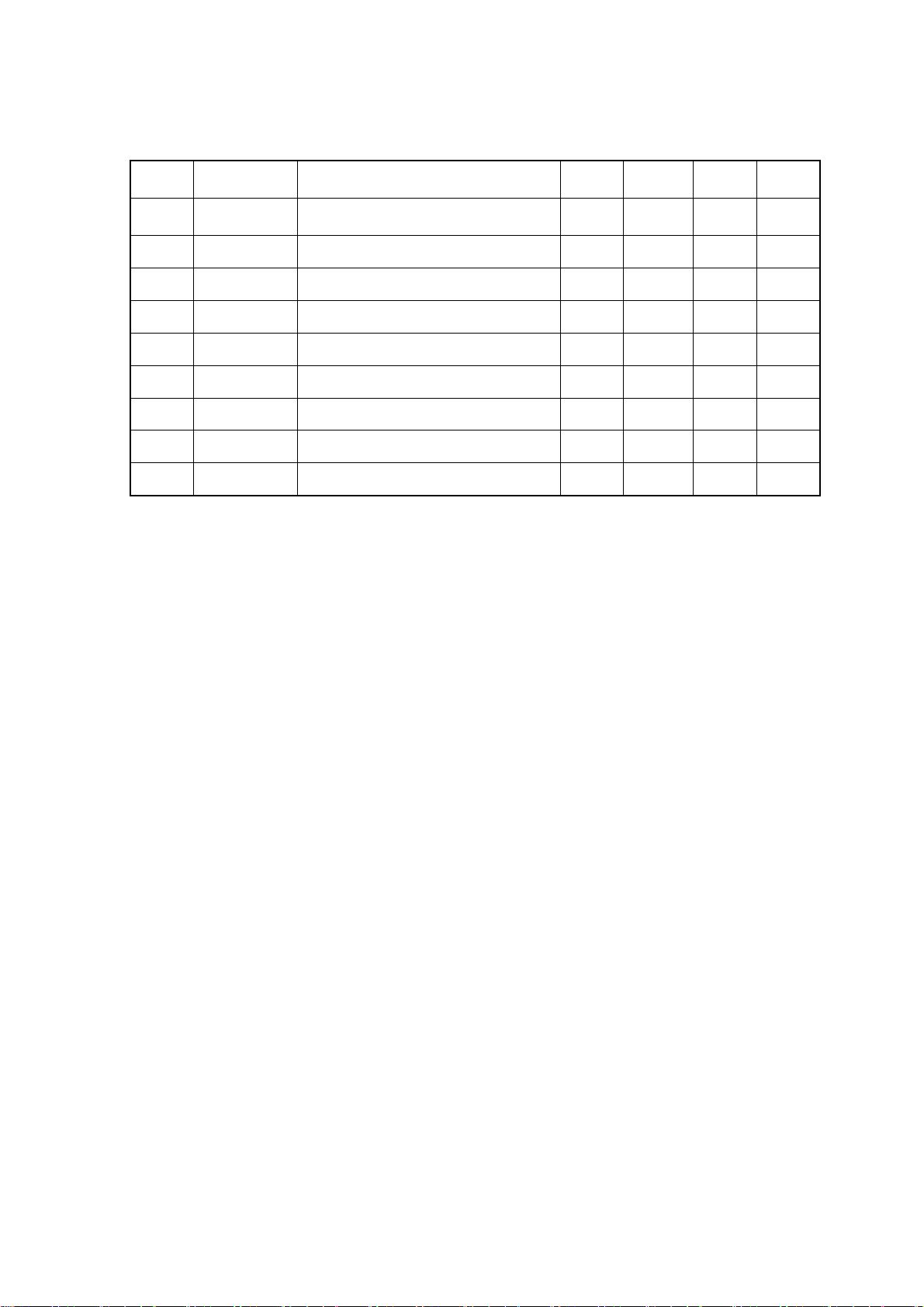

### Hadoop集群配置及MapReduce开发手册知识点梳理 #### 一、Hadoop集群配置说明 ##### 1.1 环境说明 本手册适用于基于CentOS 5系统的Hadoop集群配置,具体环境配置如下: - **操作系统**:CentOS 5 - **JDK版本**:Sun Java 6 - **SSH工具**:SSH - **IDE**:Eclipse 3.4.2 (Linux版) - **Hadoop版本**:Hadoop 0.20.0 其中,服务器地址分配如下: - **namenode**: 10.8.2.25 (server1) - **datanodes**: - 10.8.2.51 (hadoop51) - 10.8.2.52 (hadoop52) - 10.8.2.53 (hadoop53) - 10.8.2.54 (hadoop54) - 10.8.2.55 (hadoop55) - 10.8.2.56 (hadoop56) - 10.8.2.57 (hadoop57) - 10.8.2.58 (hadoop58) - 10.8.2.59 (hadoop59) ##### 1.2 目录说明 - **用户**:hadoop0200 - **用户目录**:/home/hadoop0200 - **Eclipse工程目录**:/home/hadoop0200/workspace - **Hadoop目录**:/opt/hadoop0200 - **JDK目录**:/opt/jdk1.7.0 #### 二、环境配置与安装 ##### 2.1 硬盘分区配置 - 在系统安装时,需要划分一块足够大的分区用于Hadoop的数据存储。 - 将该分区挂载到 `/data` 目录下,并以 `hadoop0200` 用户登录系统,在 `/data` 目录下创建相关目录。 - `$ cd /data` - `$ mkdir logs pids tmp dfs` - `$ cd dfs` - `$ mkdir name data` ##### 2.2 安装配置JDK - 下载JDK并存储在 `/opt` 目录下。 - 执行安装命令:`$ ./jdk-7-ea-linux-i586.bin`。 - 配置JDK环境变量: - 修改用户目录下的 `.bashrc` 文件,在文件最后添加以下配置: ```sh export JAVA_HOME=/opt/jdk1.7.0 export JAVA_JRE=$JAVA_HOME/jre export CLASSPATH=.:$JAVA_HOME/lib/tools.jar export PATH=$JAVA_HOME/bin:$JAVA_JRE/bin:$PATH:. ``` - 以 `hadoop0200` 登录,执行命令 `$ java –version` 检查是否配置成功。 ##### 2.3 安装配置Hadoop - 下载并解压Hadoop到 `/opt` 目录下,并改名为 `hadoop0200`。 - 编辑 `/opt/hadoop0200/conf/hadoop-env.sh` 文件,配置JDK路径: ```sh export JAVA_HOME=/opt/jdk1.7.0 ``` ##### 2.3.2 配置Hadoop - 配置 `hadoop-env.sh` 文件中的JDK路径。 - 配置 `core-site.xml` 和 `hdfs-site.xml` 文件中的参数,例如: - 设置HDFS的默认FS,例如指向Namenode的地址。 - 配置HDFS的数据块大小等。 - 配置 `mapred-site.xml` 文件中的参数,例如: - 设置MapReduce框架的工作目录。 - 配置 `masters` 和 `slaves` 文件来指定Namenode和Datanode。 ##### 2.4 安装配置SSH - 在所有节点上安装SSH,并配置无密码登录,以便于节点间的通信。 ##### 2.5 环境配置检验 - 使用Hadoop自带的脚本或命令检查Hadoop集群的配置是否正确。 #### 三、MapReduce开发 ##### 3.1 Hadoop Eclipse Plugin编译 - 安装Hadoop Eclipse Plugin,以方便在Eclipse IDE中进行MapReduce开发。 ##### 3.2 Eclipse Plugin配置 - 配置Eclipse中的Hadoop插件,包括设置Hadoop安装路径、JDK路径等。 - 创建一个新的MapReduce项目,选择合适的模板,如WordCount示例。 ##### 3.3 建立MapReduce工程 - 在Eclipse中创建新的MapReduce工程,编写Map和Reduce类,并进行调试。 #### 四、Hadoop性能优化 ##### 4.1 配置优化 - **内存优化**:根据实际硬件资源调整Hadoop配置文件中的内存参数。 - **Master优化**:减少Master节点的负担,如增加TaskTracker的数量。 - **文件存储设置**:优化数据块的存储位置和复制策略。 - **MapReduce临时存储**:合理配置MapReduce作业的临时文件存储位置。 - **Tasks配置**:根据作业特点和集群负载动态调整Map和Reduce任务的数量。 ##### 4.2 MapReduce工程优化 - 优化MapReduce程序的逻辑设计,比如减少Shuffle阶段的数据量。 - 调整Map和Reduce任务的并发度,提高集群资源利用率。 - 使用Combiner组件减少网络传输开销。 - 考虑使用Hadoop的其他组件,如YARN,进一步提升性能。 通过以上步骤,可以有效地配置和优化Hadoop集群,提高MapReduce程序的运行效率和稳定性。

剩余16页未读,继续阅读

z5101249972012-08-15内容不错,同意楼上,没有pdf目录。

z5101249972012-08-15内容不错,同意楼上,没有pdf目录。 lang13102013-10-24相当不错的资源

lang13102013-10-24相当不错的资源 JayChen19902012-04-15内容很清晰,东西很丰富,感谢分享啊。

JayChen19902012-04-15内容很清晰,东西很丰富,感谢分享啊。 calvin_kang2012-10-08还不错,内容很清晰!

calvin_kang2012-10-08还不错,内容很清晰! lichenga24042011-11-12非常感谢。 内容很清晰, pdf 如果有目录, 就更好了。

lichenga24042011-11-12非常感谢。 内容很清晰, pdf 如果有目录, 就更好了。

- 粉丝: 0

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功