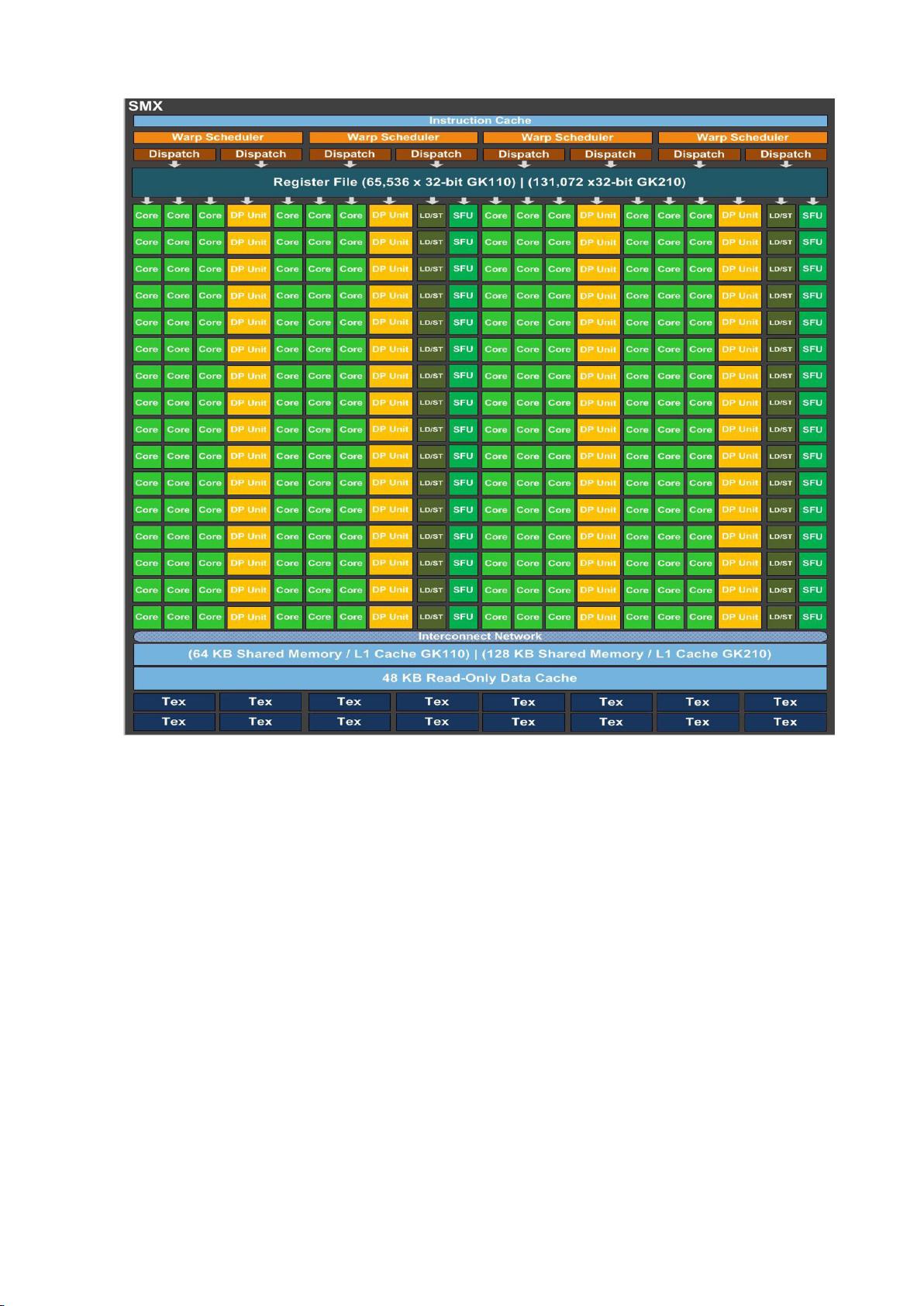

### GPU计算高级优化技术精简手册 #### 一、GPU微架构基础与优化背景 **GPU**(Graphics Processing Unit)即图形处理器,在过去几年里,随着高性能计算需求的增长,GPU因其出色的并行处理能力被广泛应用于科学计算、机器学习、深度学习等领域。本文将详细介绍GPU的高级优化技术,尤其是针对CUDA架构下的优化策略。 #### 二、CUDA设备微架构详解 ##### 1.0 CUDA设备微架构 - **Kepler架构简介**:Kepler架构是NVIDIA推出的一种先进的GPU架构,它包含了一系列功能单元,旨在提高计算效率和能效。Kepler架构的核心组成部分之一是SMX(Streaming Multiprocessor X),这是一种高度并行化的处理单元,能够高效地执行多种类型的操作。 - **SMX结构**:每个SMX包含多个关键组件,如指令预取单元、微指令缓冲区、Warp调度器、CUDA Core、SFU(Special Function Unit)、分支逻辑控制单元、LD/ST存储器访问单元等。其中,4个Warp调度器负责分配指令给不同的执行单元,而192个CUDA Core则主要负责基本的算术运算。 - **执行单元**:CUDACore支持32位单精度浮点加法、乘法、融合乘加运算等操作,同时还能执行32位整数加法以及比较操作。超越函数计算单元(SFU)用于执行复杂数学函数,如三角函数、指数和对数等。 - **存储器架构**:Kepler设备具有丰富的片上缓存结构,包括共享内存、L1缓存、纹理缓存、常量内存和只读缓存。这些缓存结构的存在是为了减少外部内存访问的次数,从而提高整体计算效率。 ##### 1.1 GCN设备微架构 GCN(Graphics Core Next)是AMD推出的GPU架构,它同样强调高性能计算能力和能效。尽管这里不详细展开GCN的具体结构,但它在设计理念和技术实现上与Kepler有着相似之处,例如都采用了高度并行化的设计思路。 #### 三、GPU矩阵乘法的高效实现 在GPU编程中,矩阵乘法是非常常见的计算任务,它的优化直接影响到应用程序的整体性能。为了提高矩阵乘法的效率,可以采用以下几种策略: - **指令级并行**:通过利用GPU内部的并行结构,让不同的执行单元同时执行不同的指令,从而提高并行度。 - **数据预取**:提前加载即将使用的数据到高速缓存中,避免在计算时等待数据加载的时间。 - **双缓冲区**:使用两组缓冲区轮流进行数据交换,这样可以在一个缓冲区中执行计算的同时,另一个缓冲区正在传输数据,从而提高数据吞吐率。 - **宽数据内存事务**:通过一次访问尽可能多地获取数据,减少内存访问次数。 - **二级数据预取**:除了数据预取之外,还可以利用二级缓存进行预取,进一步减少内存访问延迟。 #### 四、基于GPU的稀疏矩阵直接求解器 稀疏矩阵的计算通常涉及到大量的零元素,如何有效地处理这些零元素成为提高计算效率的关键。基于GPU的稀疏矩阵直接求解器主要包括以下几个步骤: - **顶点重排序**:通过对矩阵中的顶点进行重新排序,减少计算过程中遇到的零元素数量。 - **构建消去树**:通过构建消去树来确定矩阵的分解顺序,有助于简化计算过程。 - **寻找超结点**:识别出具有相似模式的矩阵子块,将其作为超结点进行处理,可以显著减少计算量。 - **符号分解**:在数值计算之前进行符号分解,可以预测哪些位置会出现非零元素,从而减少不必要的计算。 - **多波前法和超节点方法**:这两种方法结合使用可以有效处理大规模稀疏矩阵,提高计算效率。 #### 五、高性能卷积神经网络的实现 卷积神经网络(CNN)是深度学习中非常重要的模型之一,在图像识别、自然语言处理等领域有着广泛应用。为了提高CNN的运行效率,可以采用以下策略: - **基于矩阵乘法的卷积**:将卷积操作转化为矩阵乘法,利用GPU的强大计算能力加速计算过程。 - **改进-无需额外存储空间的矩阵乘法卷积**:通过优化存储策略,减少额外的内存开销,提高计算效率。 - **高效的FFT实现**:利用快速傅里叶变换(FFT)来实现卷积,这种方法在处理大尺寸卷积时特别有效。 - **采样层的高效计算**:通过优化下采样和上采样的算法,减少计算负担。 - **梯度更新的高效实现**:在反向传播过程中,通过优化偏置和激活值的更新算法,提高训练速度。 #### 六、多设备编程建议 在多GPU或多设备环境下编程时,需要注意以下几点: - **负载均衡**:确保每个设备都有足够且平衡的工作负载,避免部分设备空闲。 - **通信优化**:合理设计数据交换策略,减少设备间的数据传输时间。 - **资源共享**:在多个设备之间共享资源,比如缓存和内存,可以提高整体系统效率。 #### 七、GPU编程优化技术总结 针对不同的GPU架构(如CUDA和GCN),有不同的优化策略: - **访存优化**:优化数据访问模式,减少内存访问延迟。 - **指令优化**:减少无效指令的数量,提高指令执行效率。 - **内核调用优化**:合理设计内核函数,减少不必要的内核调用,提高并行效率。 #### 小结 GPU编程的高级优化技术涵盖了从底层架构理解到具体算法设计的各个方面。深入理解GPU的微架构特性,并结合具体的计算任务进行针对性优化,是实现高性能计算的关键。通过本文介绍的技术点,读者可以更好地理解和掌握GPU编程中的高级优化技巧,进而提高自己的编程水平。

剩余52页未读,继续阅读

AwAyfromAwAy2018-02-27好资源,非常赞

AwAyfromAwAy2018-02-27好资源,非常赞

- 粉丝: 287

- 资源: 1

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- 该仿真主要应用于路径规划和轨迹跟踪的研究 主要有五个文件(内部包含3个算法,两个仿真),1.A星算法自动生成避障的最短路径,2.两轮小车及其四轮小车的运动学建模3.纯路径跟踪算法,包括预锚点的选择算

- Edifier Connect_8.4.11.apk

- anaconda配置pytorch环境.md

- 机械设计自动倒角机sw18可编辑非常好的设计图纸100%好用.zip

- 基于28027滑膜算法的水泵驱动方案,带有初始定位算法,启动不反转,pfc采用硬件方案

- 机械设计自动PCM板胶纸机sw18非常好的设计图纸100%好用.zip

- 三相PWM整流器闭环仿真,电压电流双闭环控制,输出直流电压做外环 模型中包含主电路,坐标变,电压电流双环PI控制器,SVPWM控制,PWM发生器 matlab simulink模型 功率因数1,低TH

- anaconda配置pytorch环境.md

- Cytoscape-3-10-3-windows-64bit-仅限个人学习

- DDR3测试模块 fpga测试接口模块,提供测试模块工程 Vivado2019.1或者Vivado2017.4;语言vhdl 可以修改ip引脚,测试初始化完成

- 网络工程领域竞赛试题:网络搭建与应用的技术实战项目

- 山东大学软件学院人工智能导论22级复习资料

- 机械设计自动切断面条机ZD80sw16非常好的设计图纸100%好用.zip

- 毕设基于stm32的风机监控系统程序设计源码.zip

- 机械设计自动贴E型定位胶纸机sw18非常好的设计图纸100%好用.zip

- 机械设计自动贴E型胶纸机sw18非常好的设计图纸100%好用.zip

信息提交成功

信息提交成功