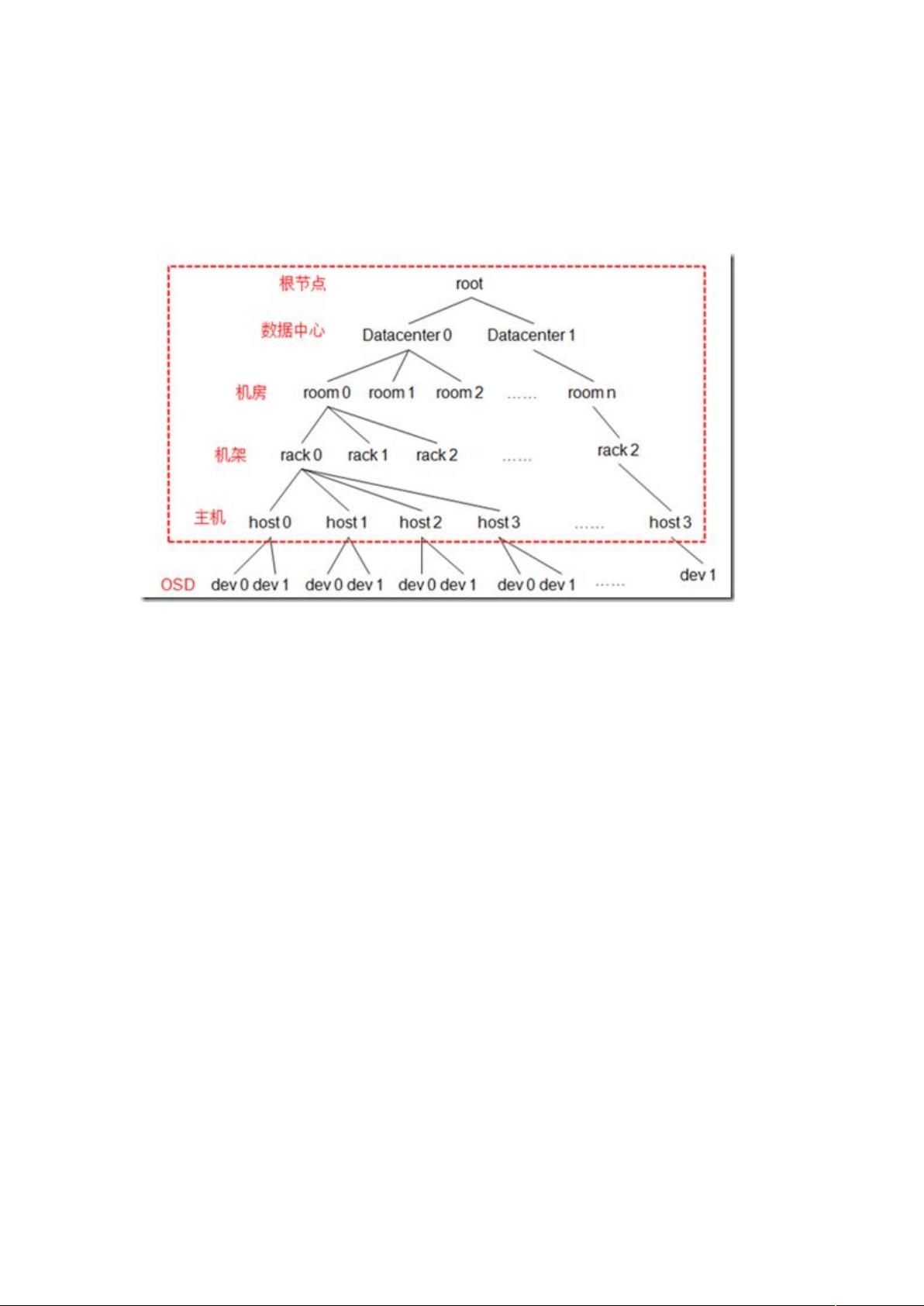

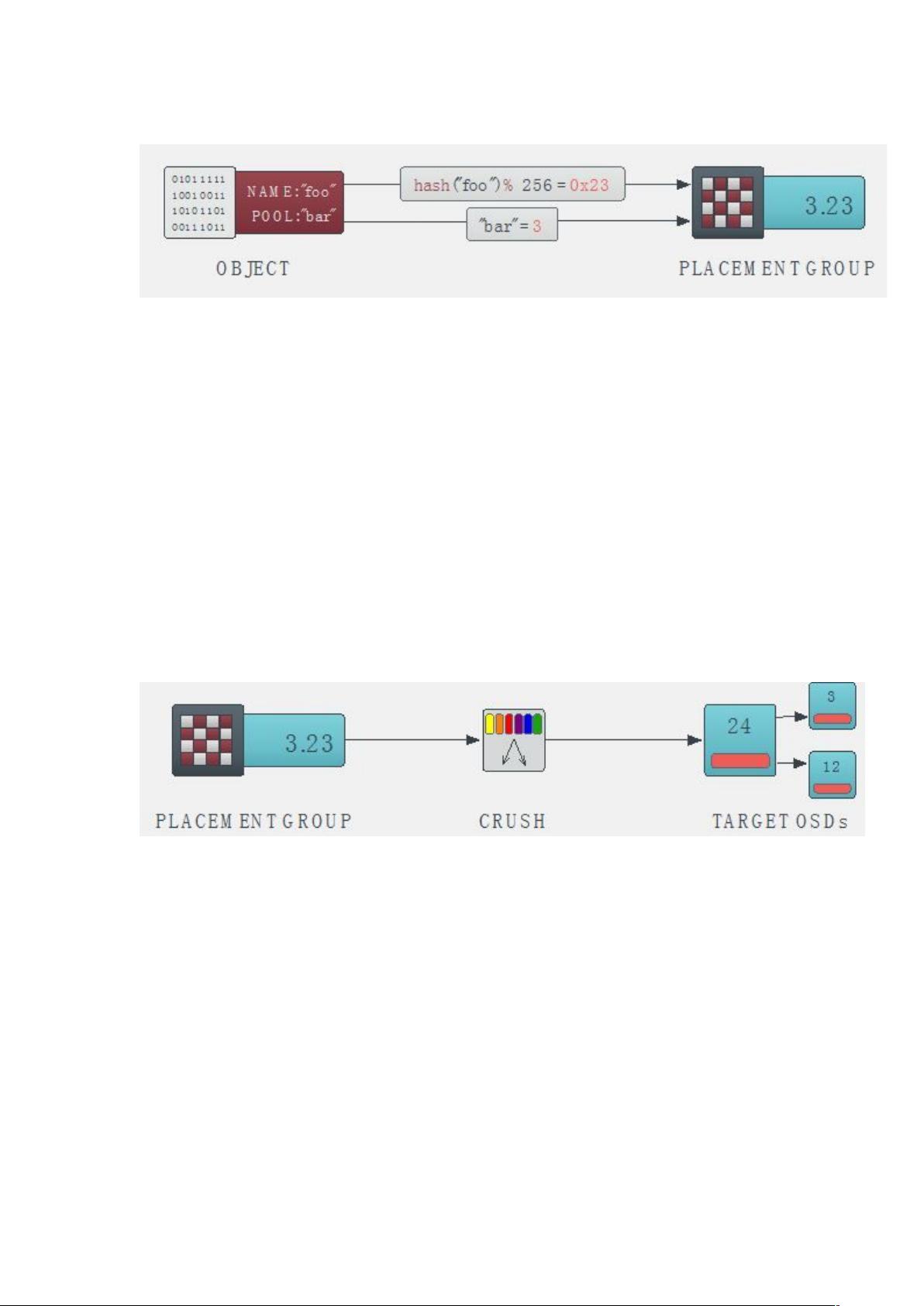

随着大规模分布式存储系统(PB级的数据和成百上千台存储设备)的出现。这些系统必须平衡的分布数据和负载(提高资源利用率),最大化系统的性能,并要处理系统的扩展和硬件失效。ceph设计了CRUSH(一个可扩展的伪随机数据分布算法),用在分布式对象存储系统上,可以有效映射数据对象到存储设备上(不需要中心设备)。因为大型系统的结构式动态变化的,CRUSH能够处理存储设备的添加和移除,并最小化由于存储设备的的添加和移动而导致的数据迁移 【Ceph CRUSH 算法详解】 Ceph 是一个高度可扩展的分布式存储系统,设计用于处理PB级别的数据和大量的存储设备。在这样的环境中,有效地分布数据和负载至关重要,以确保资源利用率最大化,系统性能最优化,并能适应扩展和硬件故障。为此,Ceph引入了CRUSH(Controlled Replication Under Scalable Hashing)算法,这是一个专门针对分布式对象存储的、去中心化的数据映射策略。 CRUSH算法的主要目标是在存储集群的动态结构中,根据预定义的规则和层次结构,将数据对象高效且均匀地映射到存储设备上,同时尽量减少因设备增减引起的数据迁移。其核心理念是通过一个确定性的伪随机函数,根据对象ID或对象组ID来确定存储设备。该函数依赖于cluster map,描述了存储集群的层级结构,以及副本分布策略,即ruleset。 CRUSH算法具有两个显著优势: 1. 去中心化:每个组件都能独立计算出对象的存储位置,无需中心控制。 2. 元数据效率:仅在设备添加或删除时才需要更新cluster map,从而降低元数据的变更频率。 CRUSH算法的映射过程涉及以下几个概念: 1. Placement Group (PG):是Ceph中数据分配的基本单位,将数据分割成多个小块,每个PG包含一定数量的对象副本。PG的数量可以通过池(pool)的属性进行配置。 2. OSD(Object Storage Daemon):存储数据的服务器节点,每个OSD对应集群中的一个物理或虚拟设备。 3. OSD Map:包含了当前所有pool的状态和OSD的状态,形成了一个树形结构,其中叶子节点是OSD,非叶子节点(bucket)可以抽象为数据中心、机房、机架或服务器等。OSD Map为CRUSH算法提供了上下文,限制了选择OSD的范围。 映射过程分为以下步骤: 1. 根据Pool的属性(如副本数和PG数)和所使用的CRUSH Ruleset,确定PG到OSD Set的映射。 2. CRUSH算法根据OSD Map中的树形结构和bucket的权重(可以基于容量或性能设定)进行计算,确定每个PG应该映射到的OSD。 3. 在树形结构中,CRUSH会采用随机策略,但又保持确定性,确保数据的均匀分布。对于不同类型的bucket(如uniform、tree等),算法有不同的处理方式,例如对于uniform bucket,采用简单的随机选择,而对于其他类型,可能涉及到更复杂的搜索算法。 通过这种映射策略,CRUSH能够实现灵活的数据分布策略,支持多种数据保护机制,如镜像复制、RAID奇偶校验或混合方法(如RAID-10),以确保大规模存储系统的可伸缩性、性能和数据安全性。简言之,CRUSH算法是Ceph中PG到OSD映射的关键,它决定了数据如何在存储集群中高效、安全地分布。

剩余22页未读,继续阅读

- 粉丝: 0

- 资源: 3

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功