# 知乎热榜爬虫+可视化 **使用说明**

## 1.Requirements:

打开文件夹, 在地址栏输入 %comspec% 并按回车

这样可以在当前目录下打开cmd

命令行输入`pip install -r requirements.txt` 并回车,安装所需要的库

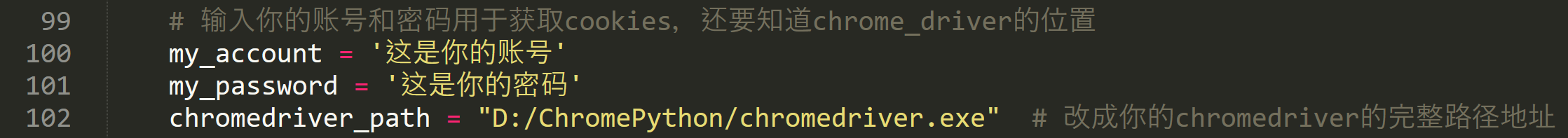

之后打开 **zhihu_crawler.py**, 将webdriver设置成自己的绝对地址,并保存

然后打开**selenium_login.py**, 进行同样的操作,并输入你的知乎的账号和密码,并保存

最后打开 **main.py** , 进行同样的操作,并保存

接下来开始运行程序,如果已经在目录下有 **ZhihuCookies.json** 的 cookies文件,请跳到第三步, 若没有则从第二步开始

## 2. 获得cookies并用cookies模拟登录知乎

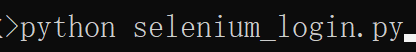

在命令行输入`python selenium_login.py`并回车

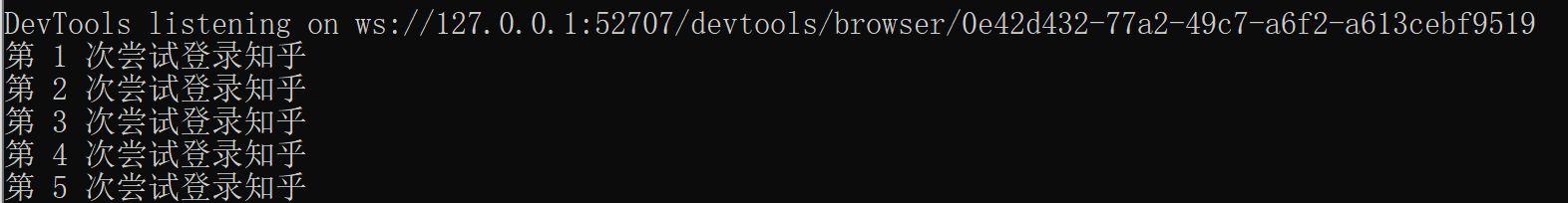

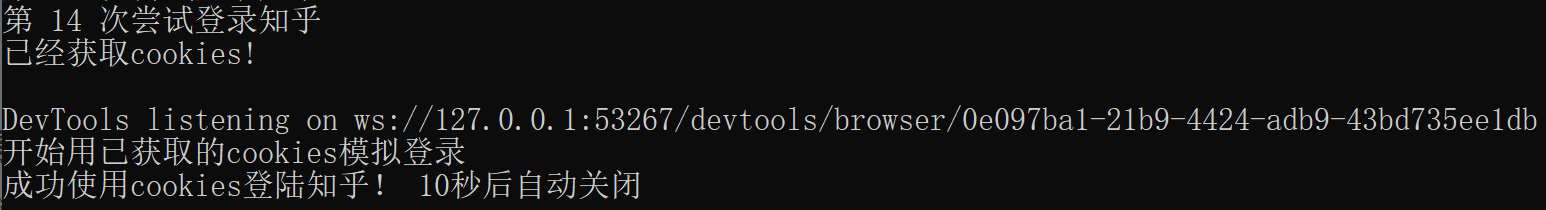

由于这里没有处理验证码的情况,所以出现验证码时请手动输入

这个时候程序会自动挂起,所以不需要担心超时问题

登陆成功以后,程序会保存cookies并自动退出,然后就用cookies实现模拟登陆知乎,开启网页10秒钟

## 3. 爬虫及可视化

继续在命令行输入 `python main.py` 并回车

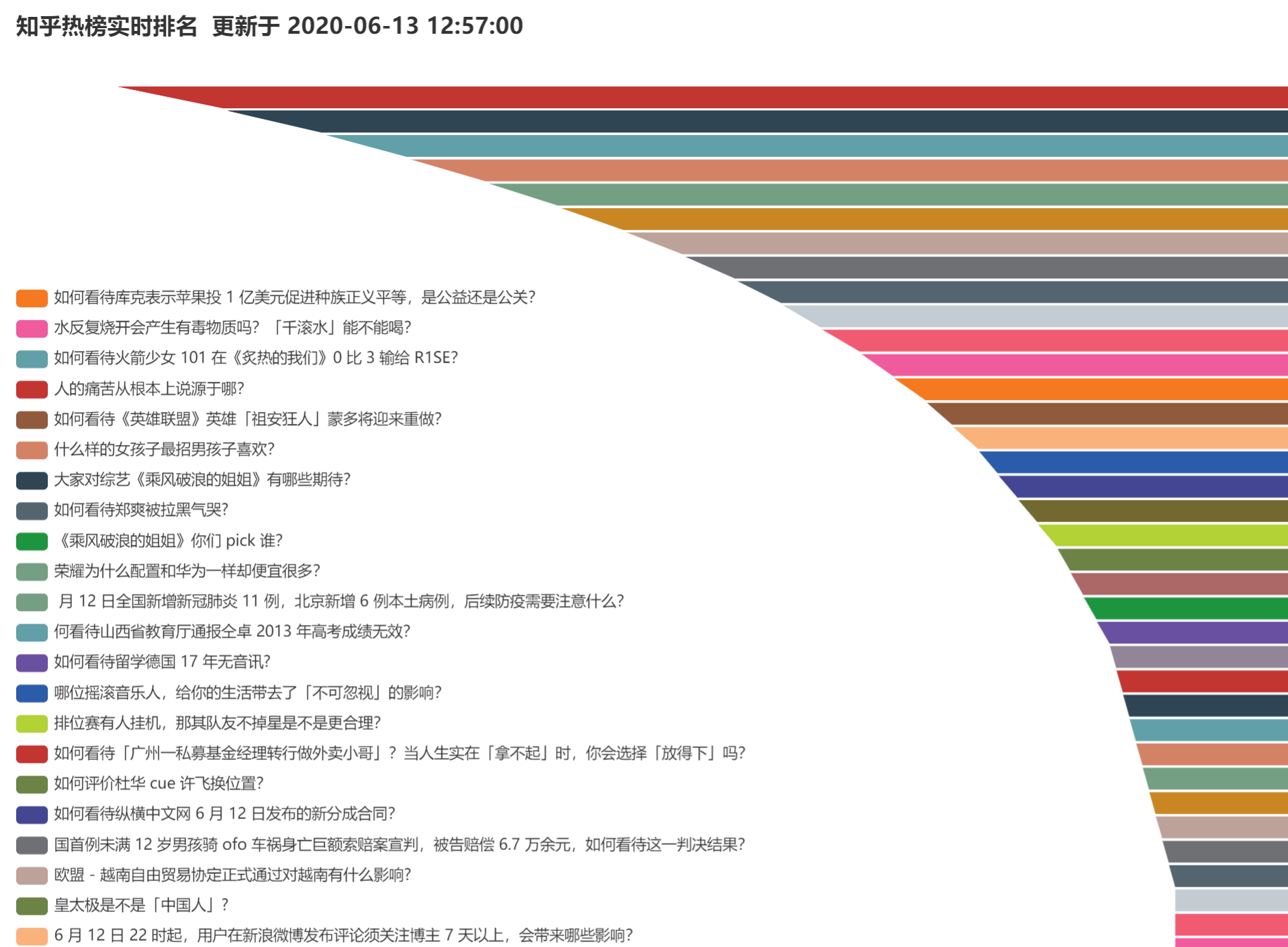

该文件会首先打开知乎网站并从热搜里面爬取前五十名的信息

爬取的内容会放在当前目录下的 **ZhihuRanking.txt** 当中

只后会进行两次可视化,第一次是普通的可视化

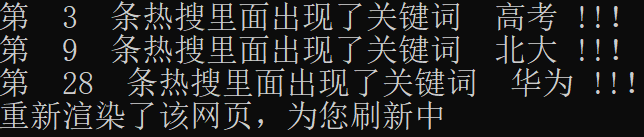

之后程序会根据自定义的关键词对热搜榜中进行匹配,将含有关键词的热搜内容提出来

并重新进行可视化,并用推特的推送声进行系统提示

这两个可视化的结果都放在当前目录下的 **知乎热搜实时排名.html** 里面

## 4.自定义部分

当前目录下 **./csv_data/config.csv** 和 **./csv_data/keywords.csv**是可以自定义的部分

**config.csv** 中可以自己定义热搜榜的刷新时间,并重新进行可视化操作,修改后保存

**keywords.csv** 中可以定义热搜榜的关键词

没有合适的资源?快使用搜索试试~ 我知道了~

温馨提示

基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip 【资源说明】 1、该资源内项目代码都是经过测试运行成功,功能正常的情况下才上传的,请放心下载使用。 2、适用人群:主要针对计算机相关专业(如计科、信息安全、数据科学与大数据技术、人工智能、通信、物联网、数学、电子信息等)的同学或企业员工下载使用,具有较高的学习借鉴价值。 3、不仅适合小白学习实战练习,也可作为大作业、课程设计、毕设项目、初期项目立项演示等,欢迎下载,互相学习,共同进步!

资源推荐

资源详情

资源评论

收起资源包目录

基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip (12个子文件)

基于selenium对知乎热搜榜进行爬虫并可视化python源码+项目说明+数据集.zip (12个子文件)  projectcode30312

projectcode30312  zhihu_crawler.py 3KB

zhihu_crawler.py 3KB main.py 5KB

main.py 5KB visualization.py 4KB

visualization.py 4KB csv_data

csv_data  keywords.csv 70B

keywords.csv 70B config.csv 18B

config.csv 18B selenium_login.py 5KB

selenium_login.py 5KB ZhihuRanking.txt 4KB

ZhihuRanking.txt 4KB mp3

mp3  twitter.mp3 16KB

twitter.mp3 16KB 知乎热榜实时排名.html 31KB

知乎热榜实时排名.html 31KB requirements.txt 57B

requirements.txt 57B .gitignore 2KB

.gitignore 2KB README.md 4KB

README.md 4KB共 12 条

- 1

资源评论

龙年行大运

- 粉丝: 1385

- 资源: 3960

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功