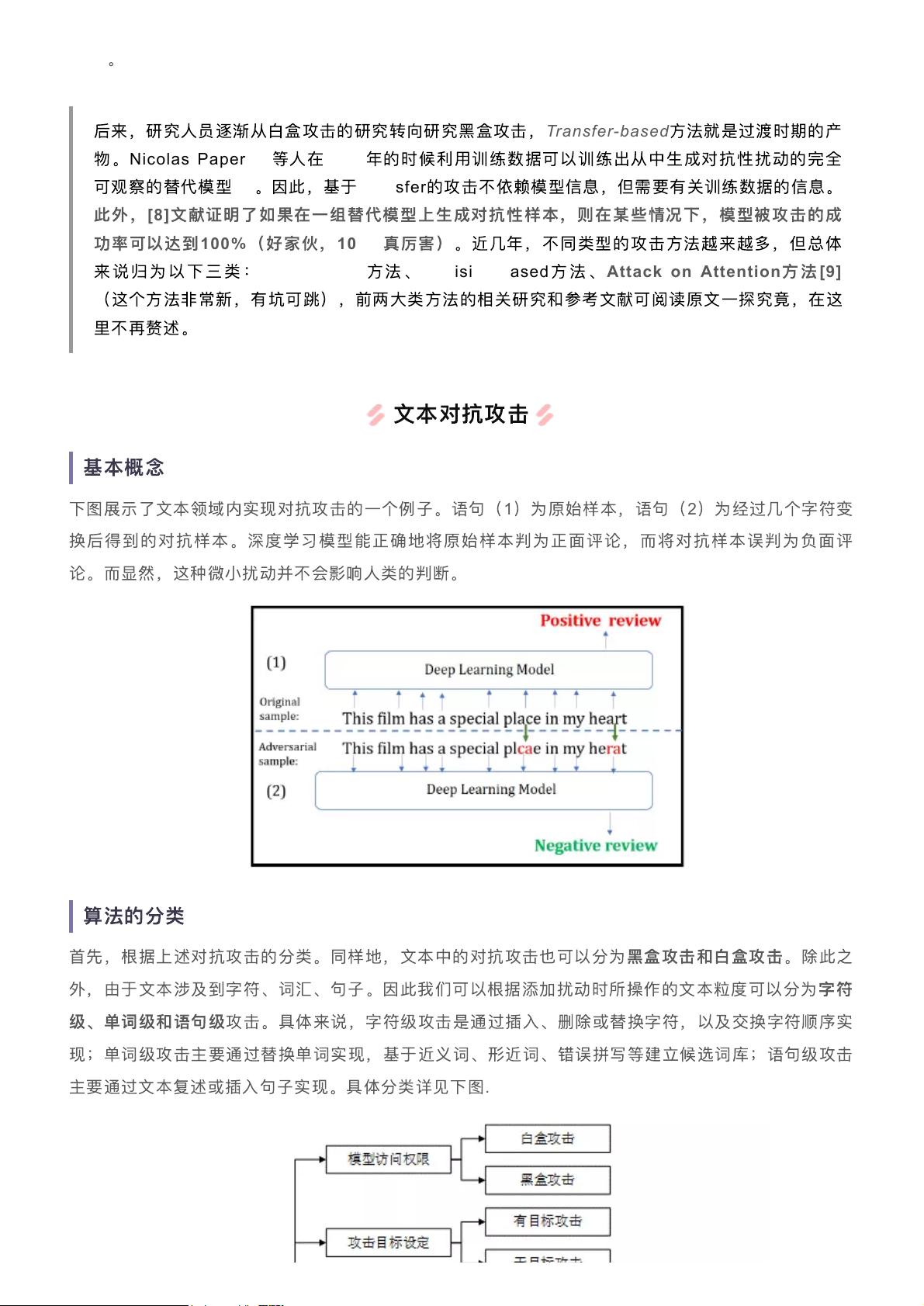

文本对抗攻击是人工智能领域,尤其是自然语言处理(NLP)中的一个重要话题,它涉及到AI的安全性和鲁棒性。在这个领域,攻击通常指的是恶意修改输入文本,以欺骗AI模型,使其产生错误的输出或决策。这样的攻击可以应用于各种场景,如语音识别、机器翻译、情感分析等。 "文本对抗攻击入坑宝典"很可能是针对这一主题的一份综合教程或指南,可能包含了对文本对抗攻击的基本概念、方法、实例和防御策略的详细讲解。"AIGC"(Artificial Intelligence Generating Content)可能是指利用AI生成内容,这在对抗攻击中可能意味着利用AI来创建对抗性样本。"AI"(Artificial Intelligence)和"NLP"(Natural Language Processing)则直接指明了讨论的焦点——AI在理解和处理自然语言时的脆弱性。"KG"(Knowledge Graph)可能涉及知识图谱,它是理解语义和上下文的重要工具,有时也可能成为对抗攻击的目标。 在压缩包内的"文本对抗攻击入坑宝典.pdf"文件中,我们预期能找到以下关键知识点: 1. **对抗性攻击定义**:解释什么是文本对抗性攻击,以及为什么这是AI和NLP领域需要关注的问题。 2. **攻击类型**:介绍不同的文本对抗攻击方式,比如基于替换、插入、删除等操作的语义保留攻击,以及深度学习模型特有的梯度基攻击等。 3. **攻击示例**:通过实例展示如何构建对抗性文本,以及这些文本如何误导AI模型。 4. **易受攻击的模型**:探讨哪些类型的NLP模型更容易受到对抗性攻击,例如基于规则的系统、统计模型或深度学习模型。 5. **评估与检测**:描述用于衡量模型对抗性能力的评估指标,以及如何检测模型是否受到攻击。 6. **防御策略**:介绍现有的防御技术,如对抗训练、输入清洗、模型鲁棒性增强等。 7. **知识图谱的抗攻击性**:如果涉及到KG,可能会讨论知识图谱在对抗攻击下的稳定性,以及如何保护知识图谱免受攻击。 8. **研究进展与未来趋势**:概述该领域的最新研究进展,以及可能的未来发展方向。 这份"宝典"可能是初学者入门的绝佳资源,涵盖了从基础概念到实际应用的全面知识,帮助读者理解并应对文本对抗攻击的挑战。通过深入阅读和理解,读者将能更好地了解AI模型的弱点,并学会如何构建更安全的系统。

文本对抗攻击入坑宝典.rar (1个子文件)

文本对抗攻击入坑宝典.rar (1个子文件)  文本对抗攻击入坑宝典.pdf 1.69MB

文本对抗攻击入坑宝典.pdf 1.69MB- 1

- 粉丝: 2w+

- 资源: 635

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功