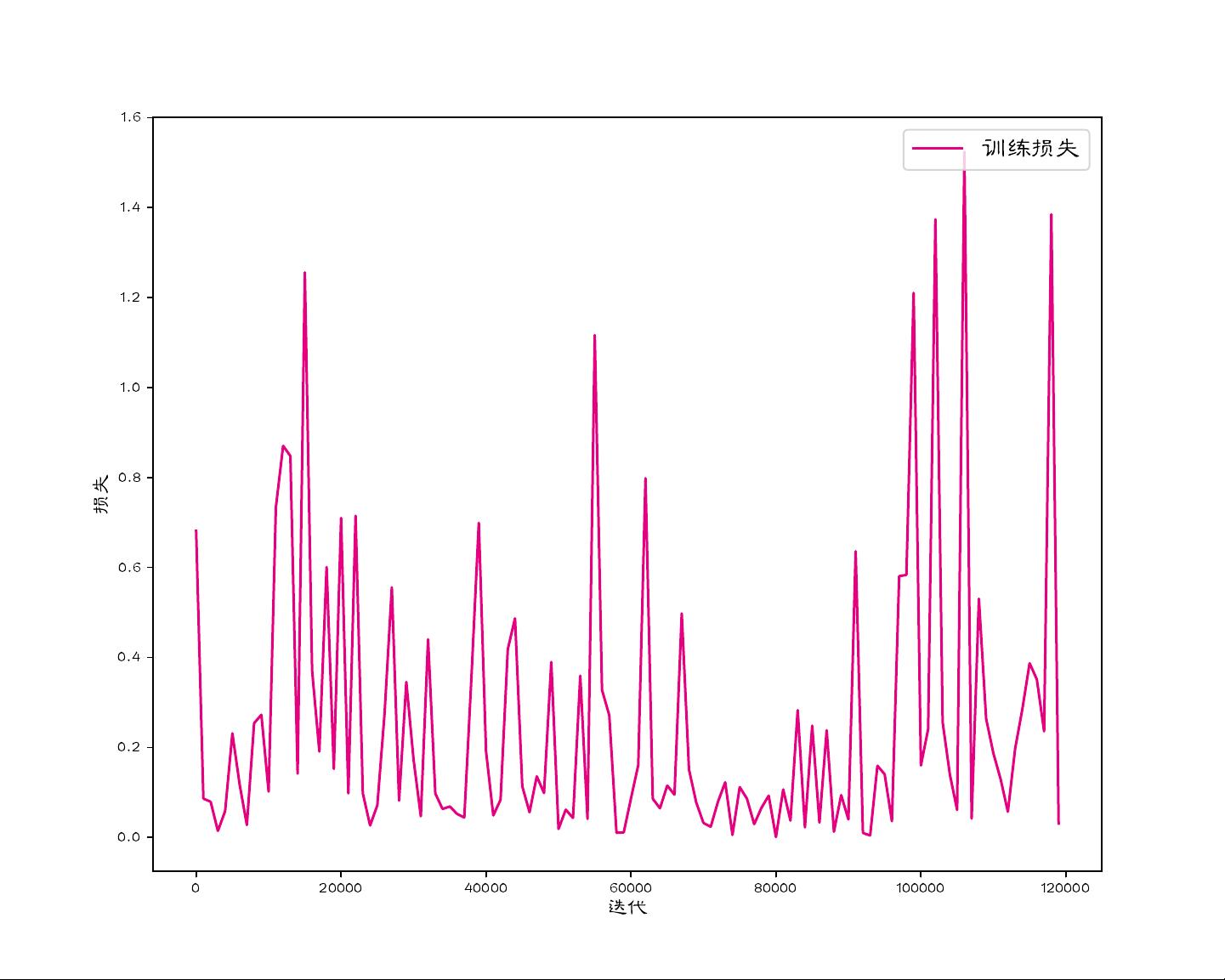

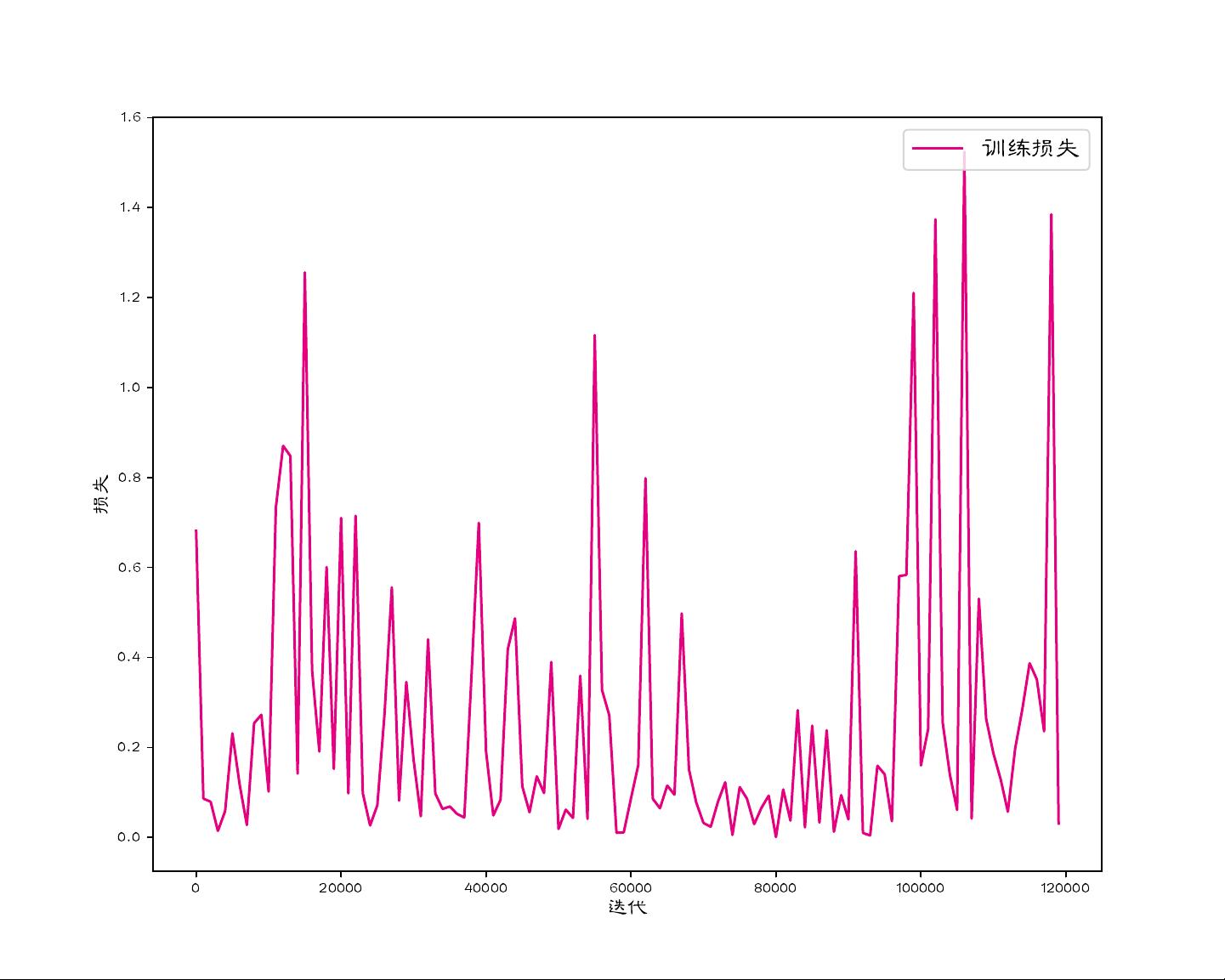

在自然语言处理(NLP)领域,文本语义匹配任务是一项关键的应用,它涉及判断两个或多个文本之间的语义相似度或相关性。本资源提供了一个使用Python编程语言,基于预训练大模型RocketQA进行微调来实现文本语义匹配的完整解决方案。RocketQA是由阿里云开发的一种高效的问答模型,其在多项问答任务上表现出优秀的性能,通过微调可以适应不同的下游任务,如文本匹配。 我们来理解一下预训练模型。预训练模型是通过大规模无标注文本数据进行学习得到的,如BERT、RoBERTa、ALBERT等。这些模型在大型语料库上进行了自我监督学习,学会了丰富的语言表示。预训练后,这些模型可以针对特定任务进行微调,即在有标注的数据集上进行少量的额外训练,以提高在目标任务上的性能。 RocketQA则是这样的预训练模型之一,尤其优化了问答任务。在这个项目中,我们用RocketQA对文本语义匹配任务进行微调,这意味着我们将使用RocketQA的基础参数,并在匹配任务的数据集上进行训练,以使模型更好地理解和处理文本的语义关系。 为了实现这个任务,你需要以下步骤: 1. **环境配置**:确保你有一个合适的Python开发环境,比如Anaconda或Miniconda,用于管理依赖库。你需要安装相关的库,如transformers(包含RocketQA模型)、torch(PyTorch深度学习框架)以及其他的NLP工具。 2. **数据集准备**:数据集是微调过程中的关键部分。提供的压缩包可能包含了用于训练和验证模型的语义匹配数据集。这些数据通常由成对的文本和它们的相关性标签(如匹配或不匹配)组成。你需要将数据加载到Python程序中,进行必要的预处理,如分词、去除停用词、标准化等。 3. **模型加载与微调**:利用transformers库加载RocketQA模型。然后,定义损失函数和优化器,设置微调的超参数,如学习率、批次大小和训练轮数。在训练过程中,模型会根据输入的文本对和相应的标签调整其权重,以最大化预测正确标签的概率。 4. **评估与调优**:在验证集上定期评估模型的性能,这通常通过计算精度、召回率、F1分数等指标完成。根据评估结果,你可能需要调整模型结构、超参数或者增加训练轮数来优化模型性能。 5. **推理与应用**:完成微调后,你可以使用训练好的模型进行文本语义匹配。输入一对文本,模型将输出它们的相似度分数,根据阈值判断是否匹配。 6. **代码结构**:`text-semantic-matching-master`很可能包含了项目的主要文件结构,如`data`目录存储数据集,`model`目录包含模型相关的代码,`utils`可能包含一些辅助函数,`train.py`可能是主要的训练脚本,`evaluate.py`用于模型评估。 掌握以上步骤,你就能充分利用提供的资源,实现自己的文本语义匹配系统。在实际应用中,这种技术可以用于问答系统、信息检索、情感分析等多个场景。

text-semantic-matching-master.zip (13个子文件)

text-semantic-matching-master.zip (13个子文件)  text-semantic-matching-master

text-semantic-matching-master  LICENSE 9KB

LICENSE 9KB .gitignore 350B

.gitignore 350B 基于RocketQA的文本语义匹配

基于RocketQA的文本语义匹配  utils.py 2KB

utils.py 2KB main.ipynb 163KB

main.ipynb 163KB iamges

iamges  score.pdf 17KB

score.pdf 17KB loss.pdf 17KB

loss.pdf 17KB dataset

dataset  lcqmc

lcqmc  train.tsv 15.74MB

train.tsv 15.74MB dev.tsv 674KB

dev.tsv 674KB License.pdf 190KB

License.pdf 190KB simnet_vocab.txt 4.78MB

simnet_vocab.txt 4.78MB User_Agreement.pdf 175KB

User_Agreement.pdf 175KB test.tsv 734KB

test.tsv 734KB __pycache__

__pycache__  utils.cpython-310.pyc 2KB

utils.cpython-310.pyc 2KB- 1

weixin_521282152024-07-04资源内容详尽,对我有使用价值,谢谢资源主的分享。

weixin_521282152024-07-04资源内容详尽,对我有使用价值,谢谢资源主的分享。

- 粉丝: 8295

- 资源: 1469

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

信息提交成功

信息提交成功