# ZhihuSpider

User spider for www.zhihu.com

## 1.Install python3 and packages

Make sure you have installed python3.

Using pip to install dependencies.

``` bash

pip install Image requests beautifulsoup4 html5lib redis PyMySQL

```

## 2.Database Config

Install `mysql`,create your database.

Import `init.sql` to create your table.

## 3.Install redis

``` bash

# (ubuntu)

apt-get install redis

# or (centos)

yum install redis

# or (macos)

brew install redis

```

## 4.Config your application

Complete config.ini

## 5.Get start

``` bash

python get_user.py

# or command python3

python3 get_user.py

```

## 中文

在我的博客里有代码的详细解读:[我用python爬了知乎一百万用户的数据](http://www.jwlchina.cn/2016/11/04/%E6%88%91%E7%94%A8python%E7%88%AC%E4%BA%86%E7%9F%A5%E4%B9%8E%E4%B8%80%E7%99%BE%E4%B8%87%E7%94%A8%E6%88%B7%E7%9A%84%E6%95%B0%E6%8D%AE/)

数据统计分析:[百万知乎用户数据分析](http://zhihu.jwlchina.cn/)

# 这是一个多线程抓取知乎用户的程序

# Requirements

需要用到的包:

`beautifulsoup4`

`html5lib`

`image`

`requests`

`redis`

`PyMySQL`

pip安装所有依赖包:

``` bash

pip install Image requests beautifulsoup4 html5lib redis PyMySQL

```

运行环境需要支持中文

测试运行环境python3.5,不保证其他运行环境能完美运行

1.**需要安装mysql和redis**

2.**配置`config.ini`文件,设置好mysql和redis,并且填写你的知乎帐号(master分支新版爬虫不需要登陆,但是可能会有时效问题,可以切换至new-ui分支使用)**

可以通过配置`config.ini`文件下的`[sys]` `sleep_time` 控制爬虫速度(尽量使用推荐值,过快容易被知乎封禁),`thread_num`配置线程数目

3.**向数据库导入`init.sql`**

# Run

开始抓取数据:`python get_user.py`

查看抓取数量:`python check_redis.py`

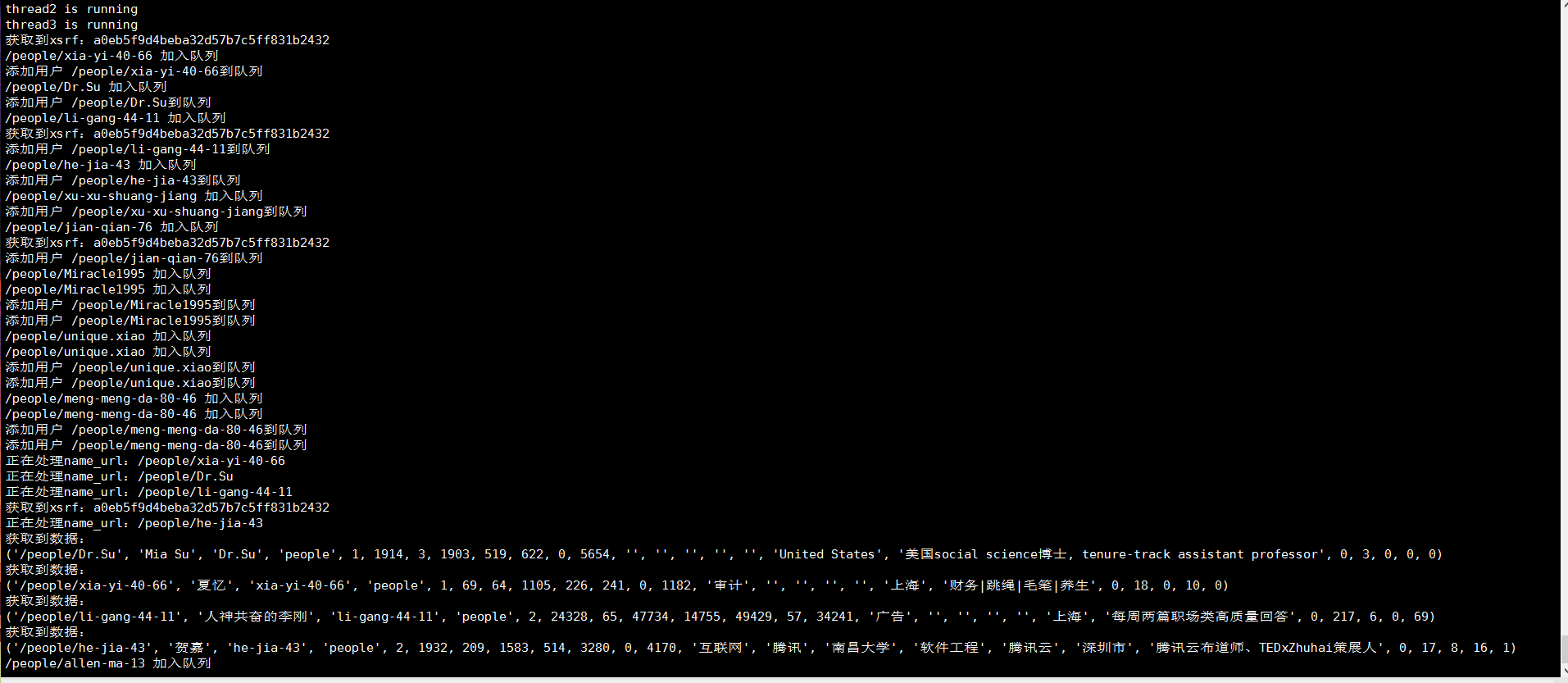

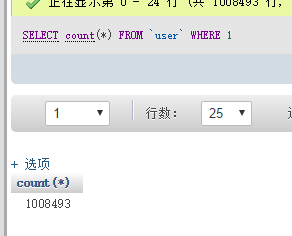

# 效果

# Docker

嫌麻烦的可以参考一下我用docker简单的搭建一个基础环境:

mysql和redis都是官方镜像

```bash

docker run --name mysql -itd mysql:latest

docker run --name redis -itd redis:latest

```

再利用docker-compose运行python镜像,我的python的docker-compose.yml:

``` bash

python:

container_name: python

build: .

ports:

- "84:80"

external_links:

- memcache:memcache

- mysql:mysql

- redis:redis

volumes:

- /docker_containers/python/www:/var/www/html

tty: true

stdin_open: true

extra_hosts:

- "python:192.168.102.140"

environment:

PYTHONIOENCODING: utf-8

```

我的Dockerfile:

``` bash

From kong36088/zhihu-spider:latest

```

# 捐赠

您的支持是对我的最大鼓励!

谢谢你请我吃糖

没有合适的资源?快使用搜索试试~ 我知道了~

温馨提示

【资源说明】 基于python3多线程知乎用户爬虫详细文档+资料齐全.zip 【备注】 1、该项目是个人高分项目源码,已获导师指导认可通过,答辩评审分达到95分 2、该资源内项目代码都经过测试运行成功,功能ok的情况下才上传的,请放心下载使用! 3、本项目适合计算机相关专业(人工智能、通信工程、自动化、电子信息、物联网等)的在校学生、老师或者企业员工下载使用,也可作为毕业设计、课程设计、作业、项目初期立项演示等,当然也适合小白学习进阶。 4、如果基础还行,可以在此代码基础上进行修改,以实现其他功能,也可直接用于毕设、课设、作业等。 欢迎下载,沟通交流,互相学习,共同进步!

资源推荐

资源详情

资源评论

收起资源包目录

基于python3多线程知乎用户爬虫详细文档+资料齐全.zip (9个子文件)

基于python3多线程知乎用户爬虫详细文档+资料齐全.zip (9个子文件)  ZhihuSpider-master

ZhihuSpider-master  check_redis.py 395B

check_redis.py 395B init.sql 1KB

init.sql 1KB get_user.py 18KB

get_user.py 18KB config.ini 234B

config.ini 234B .gitignore 52B

.gitignore 52B README.md 3KB

README.md 3KB login

login  __init__.py 0B

__init__.py 0B login.py 6KB

login.py 6KB CSDN

CSDN  软件

软件  项目授权码.txt 268B

项目授权码.txt 268B共 9 条

- 1

资源评论

Yuki-^_^

- 粉丝: 3099

- 资源: 781

上传资源 快速赚钱

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

资源上传下载、课程学习等过程中有任何疑问或建议,欢迎提出宝贵意见哦~我们会及时处理!

点击此处反馈

安全验证

文档复制为VIP权益,开通VIP直接复制

信息提交成功

信息提交成功