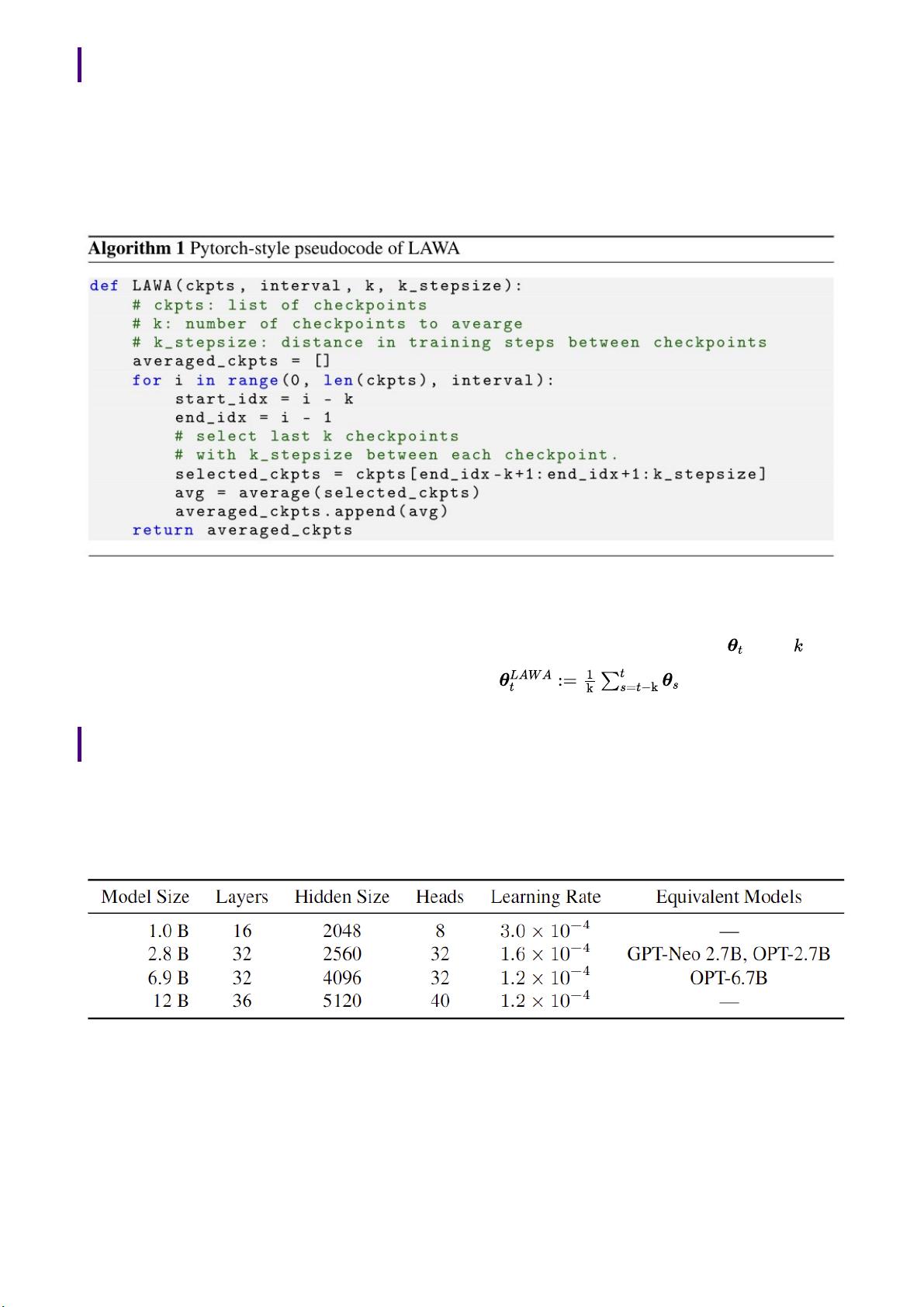

在AI领域,特别是大型语言模型(LLM)的训练中,模型的稳定性和效率是至关重要的问题。传统的训练策略往往追求模型的完全收敛,但近年来的研究揭示了一个令人意想不到的技巧——提前停止训练并采用最近权重平均(LAWA)方法可以显著提升模型的稳定性和性能,同时还能减少计算资源的消耗。 LAWA方法的核心思想是在训练过程中,不等待模型完全收敛,而是对训练过程中的一系列中间检查点进行权重平均。这种方法基于一个移动窗口,定期选取最近的k个检查点进行加权平均,形成一个新的模型状态。这种策略不仅能够加速模型的收敛速度,还可以在模型未达到完全收敛前就获得较好的性能,尤其是在零样本(zero-shot)情况下的表现。 论文《Understanding the Effectiveness of Early Weight Averaging for Training Large Language Models》深入探讨了LAWA对LLM训练的影响。实验结果显示,LAWA可以在不增加额外成本的情况下,显著减少GPU的使用时间,从而降低云计算成本。对于不同规模的GPT风格的自回归LLM,从10亿到120亿参数的模型,LAWA均展示了更快的收敛速度和更好的测试泛化能力。 在中等规模的LLM,如Pythia-1B和Pythia-2.8B模型中,LAWA检查点在多个任务上的测试泛化性能超越了传统训练保存的检查点。对于更大规模的Pythia-6.9B和Pythia-12B模型,LAWA在训练早期和中期显著提升了测试泛化,而在训练后期改善相对较小,但仍能观察到积极的效果。 这些发现挑战了传统的LLM训练观念,表明在追求模型性能的同时,不必过于执着于完全收敛。通过LAWA这样的策略,研究者和开发者可以更加高效地利用计算资源,同时提高模型的稳定性和实际应用效果。在未来的LLM训练实践中,LAWA有望成为一种被广泛采用的优化技巧,以实现更高效、更稳定的模型训练流程。

剩余9页未读,继续阅读

- 粉丝: 1264

- 资源: 5619

我的内容管理

展开

我的内容管理

展开

我的资源

快来上传第一个资源

我的资源

快来上传第一个资源

我的收益 登录查看自己的收益

我的收益 登录查看自己的收益 我的积分

登录查看自己的积分

我的积分

登录查看自己的积分

我的C币

登录后查看C币余额

我的C币

登录后查看C币余额

我的收藏

我的收藏  我的下载

我的下载  下载帮助

下载帮助

前往需求广场,查看用户热搜

前往需求广场,查看用户热搜最新资源

- (源码)基于Arduino和Firebase的智能家庭管理系统NodeSmartHome.zip

- (源码)基于C++的East Zone DSTADSO Robotics Challenge 2019机器人控制系统.zip

- (源码)基于Arduino平台的焊接站控制系统.zip

- (源码)基于ESPboy系统的TZXDuino WiFi项目.zip

- (源码)基于Java的剧场账单管理系统.zip

- (源码)基于Java Swing的船只资料管理系统.zip

- (源码)基于Python框架的模拟购物系统.zip

- (源码)基于C++的图书管理系统.zip

- (源码)基于Arduino的简易温度显示系统.zip

- (源码)基于Arduino的智能电动轮椅系统.zip

信息提交成功

信息提交成功